こんにちは、magです。

本日は前回に引き続き、HTMLを学習しました。

“ゼミの振り返り(2023/06/12)” の続きを読むこんにちは!magです!

タイトルにもある通り、やる気が出たので自転車で遠出してきました!

今回の目的地は、以前から気になっていた夜間瀬です!

「よませ」って読むんですけど、なんかカッコよくないですか??

そんな軽い気持ちで行ってきました。

“自転車で遠出してきました!” の続きを読む明けましておめでとうございます。

新年一発目のブログかと思いきや、そうでも無いですね笑

前回の構想編に引き続き、magが担当します!

今回は発表会となりました!

“生活をちょっとだけ豊かにするものづくり(2022年12月22日)” の続きを読むこんにちは、magです。

長野県はいよいよ本格的に冬到来というところでしょうか……

お布団くんがなかなか離してくれない日々が続きそうですね。

話題は変わりまして、今回はゼミの振り返りを行いたいと思います。

今回のゼミでは、題名にもある通り、

「生活をちょっとだけ豊かにするものづくり」

をテーマに、活動を行いました。

この活動はゼミ2回分にわたって行う予定で、今回は構想の段階でした。

まず身の回りで困っていることについて考えたり、使用する工具から逆算して考えたりと人によって考え方は様々でした!

FabLabをお借りして行ったので、3Dプリンターやレーザーカッターなど必要な道具はとても充実しています!

2週間後(12/22)に製作物の発表があるので楽しみです!

また、製作物の発表が終わり次第、ブログ更新します!お楽しみに!

メインの振り返りは終わりで、次はゼミ長からの小話を紹介します。

ゼミの最初にゼミ長から、大学の講義で聞いた面白い話をしてくれました。

簡潔に説明すると、「信州大学の1授業にかかるお金は約2900円で、怠惰や怠慢を理由に休むともったいないよ」という内容でした。

2900円って大学生にとっては高額ですよね……

当時、私もその講義を受講していましたが、教えて下さった先生のトークスキルも相まって、とても感動したことを覚えています。

最近講義を休みがちな私に、グサッと刺さる内容でした。改心します。

※※※他の記事も興味がありましたら、下からご覧下さいませ。※※※

こんにちは!magnetです。 最近寒くなりましたね。外気温が低くて研究室がなかなか温まりません。 そんなご時…

こんにちは、今回は授業で作ったWebアプリケーションの紹介・解説を行いたいと思います。 言語:python3.…

こんにちは。信州大学 教育学部 小倉研2年の peace です。 作品紹介ページの記念すべき第1回目の投稿は、…

こんにちは!magです。

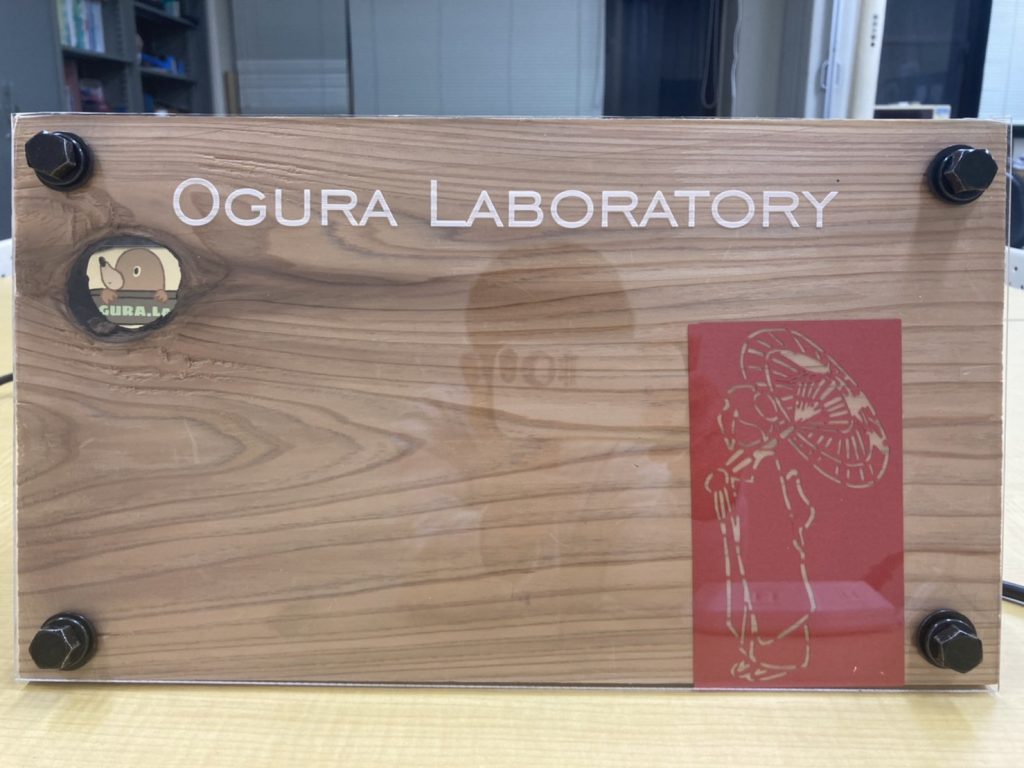

今回は成果物として研究室の看板を紹介したいと思います!

まずはきっかけの紹介です!

ある日ふと他の研究室にお邪魔する際に

他の研究室の入り口を見てみると、

個性豊かな看板が貼り付けられていました……

そういえばうちには何も飾られていないなあと思い、

じゃあ作っちゃえば良いじゃない!!と

思い立ちました。

小倉先生に伺ったところ、「自由に作っていいよ!」とのことだったので

自由に作らせていただきました笑

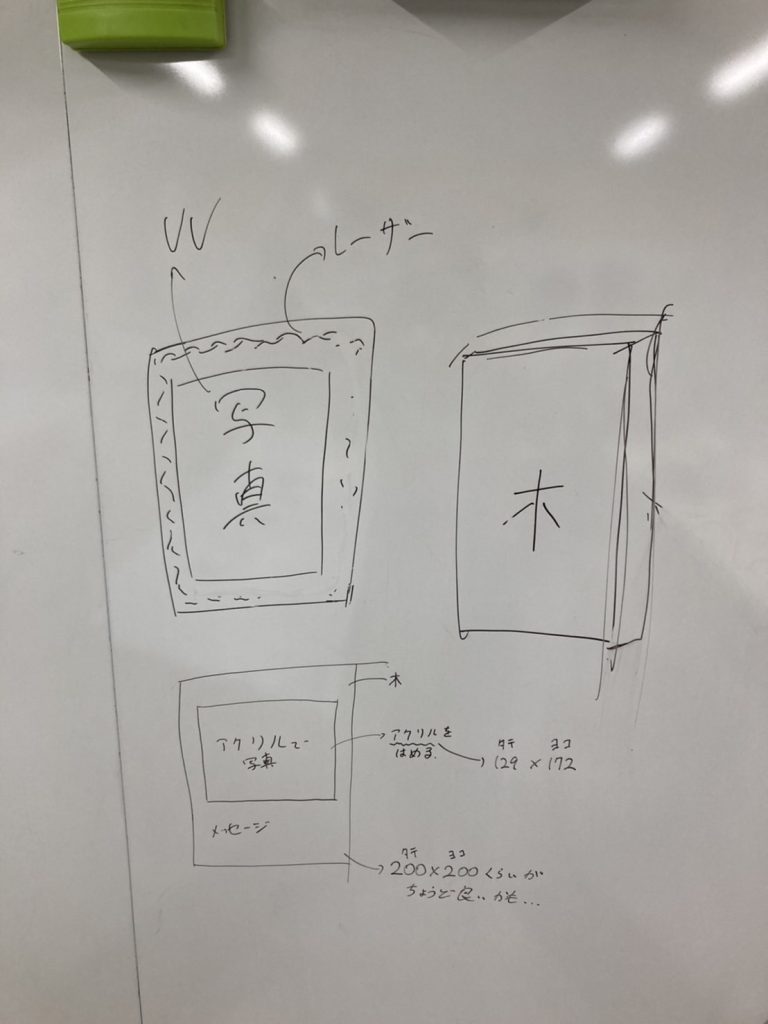

そうなるとまずは構想からしなくてはなりません。

いろいろ、思考を巡らせました。

小倉先生にも構想を伺って

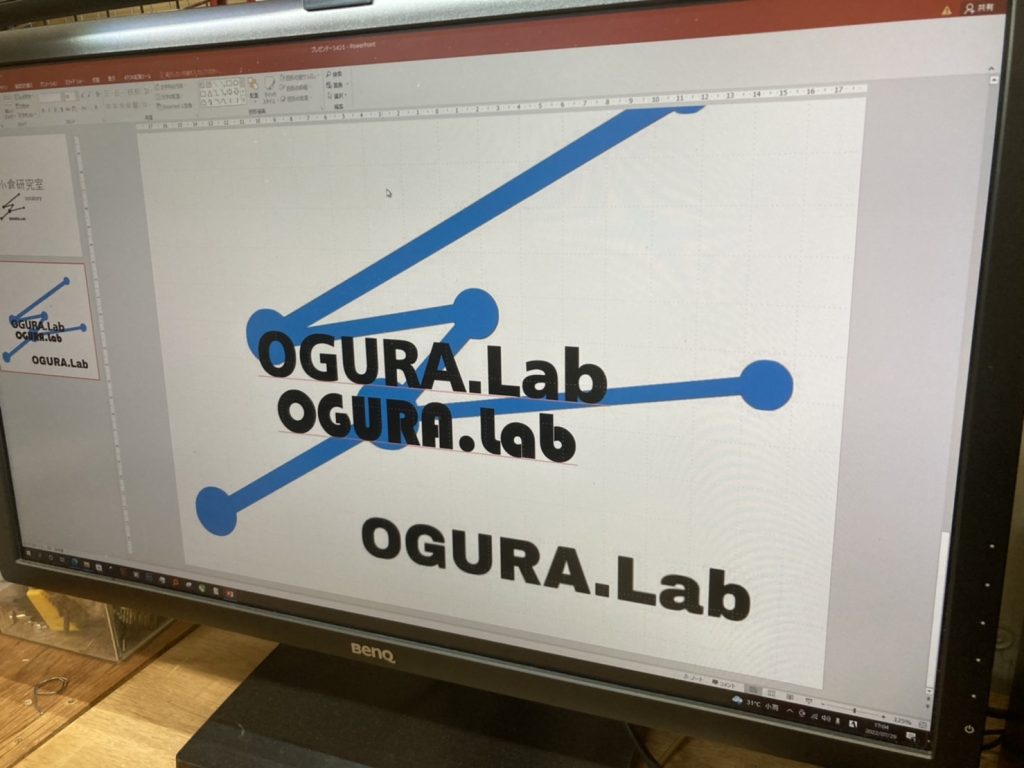

その後3DプリンタやUVプリンタを使って

フォントや、印字の具合、色の出方などなど試行錯誤を重ねていきました。

何度も下準備を重ねた上で、本番行きましょう!

まずは良さげな木材と頑丈そうなプラ板を用意して、

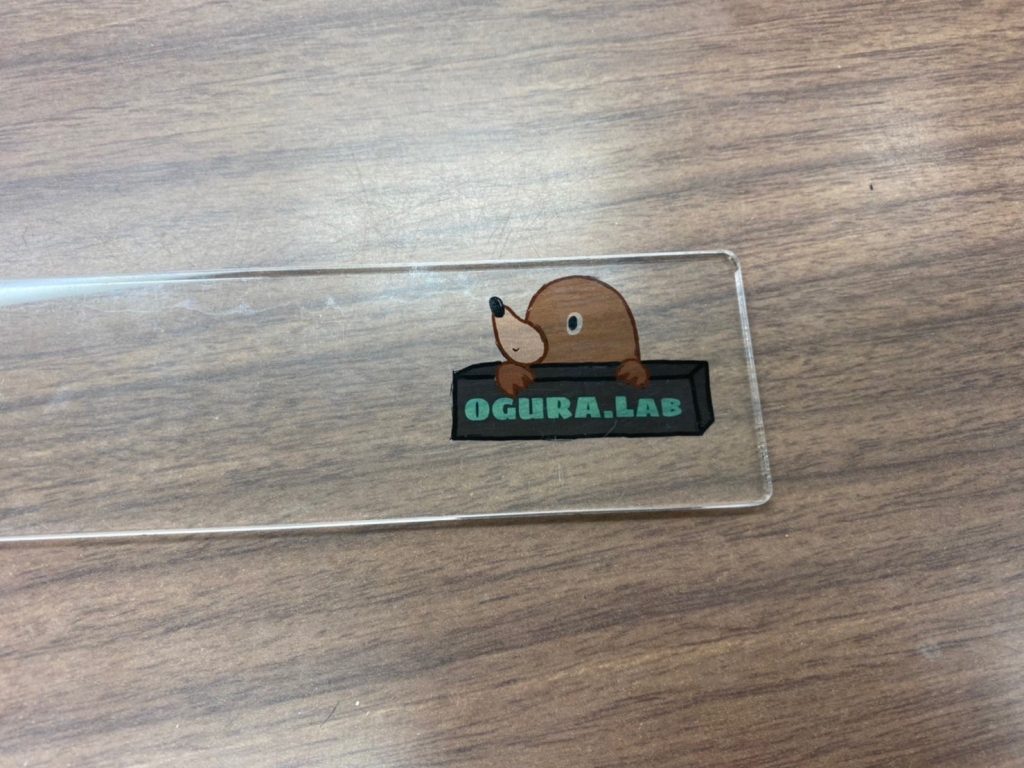

いよいよ下準備したデータたちを、印刷していきます……ドキドキ……

そして完成品がこちらです!

左上のマスコットキャラクターがとっても可愛いですね^^

真ん中のスペースには、集合写真なんかが入れられたら良いなあなんて思っています。

これをオープンキャンパスの時に見て「明るい雰囲気の研究室なんだなあー」って

思って帰ってもらうだけでも大成功な気がします。

私は授業が被っていて参加出来ていませんが、最近のゼミでもお披露目したところ、評判だったようです!

長期間かけて作った甲斐があって良かったです!

今後はドアへの設置方法や入れ込む写真について検討していければと考えています。

まだまだ、完璧に完成するまでには時間がかかりそうですね。

これからどうなっていくのかがとても楽しみです!!

以上、成果物のブログをmagがお送りしました。

最近更新されたブログ以下に載せておきますので、是非ご覧になって下さい!

こんにちは、小倉研4年のpeaceです。peaceの夏休み 第3回目は、北陸旅2日目の石川県について書こうと思…

こんにちは、ゆうです。 大学生の夏休みは小中高学生に比べ「長い」と言われていますが、なんだかんだで完全な休みが…

こんにちは、小倉研4年のpeaceです。peaceの夏休み 第2~4回目は、8/25~27で行ってきた北陸旅に…

こんにちは。magnetです。

最近、何かと忙しくて時間に追われています。

充実している反面、これで良いのか自問自答しています笑

ところで、本日 (5/8) はゴールデンウィークの終盤ですね。

私は実家に帰りましたが、どこかに行きたい欲があり、

浜松まで行ってきました。

目的地を1つ決めて、その前後に

時間が許す限りどこかへ行く

と言った具合です。

最初に SWEETS BANK というところに行って来ました。

めちゃくちゃきれいでした。そしてカップル多かった……

カフェが併設されているので、お昼を食べようとしたら…

驚異の1時間半待ちでした。

ゴールデンウィークだからしょうがない…

日帰りの身からすると、時間が惜しかったので、渋々諦めました……

日帰りは、割り切りが大事なのです…泣

今度は是非食べに行きたい!

次は、浜松城 に行こうと思い、

バス停まで行くと、近い時間が無い!ことに気づきました。

「じゃあ歩いて行きます(40分)」

1人旅ならではの思考ですね笑

住宅街とかをただただ歩くことも好きですから、

全然、苦では無かったですよ。ええ。

そして辿り就いた浜松城。

長い道のりでしたが、景色が良かったです。

天気が良いと富士山がうっすら見えるとのことでしたが、

残念ながら、私の目には、映らなかったです……

景色全般、撮るの忘れましたが。

最後は、徳川家康にご挨拶して帰りましたとさ。

そういえば、誕生日一緒なんだとか。

なんか縁を感じますね。

ここまで、浜松へのぶらり旅を報告しましたが、

なんか煮え切らない思いでいっぱいです。

今度は、誰かと一緒に、車で、行きたいです。

以上、magnetのぶらり旅報告でした!

では、また!

どうも。magnetです。

最近の情報系の授業において、「スクレイピング」というものを学びました。

スクレイピングについて詳しく知りたい方は、

「ゆう」が書いたこちらの記事をどうぞ~

その授業で各自製作の課題が課されたので、

とあるサイトをスクレイピングしてみました!!

以下に私が書いたコードを載せておきますね~。

import requests

from bs4 import BeautifulSoup

# importでrequestとbs4のBeautifulsoupを読み込みます。

# Webページを取得して解析する

load_url = "とあるサイトのURL"

# とあるサイトのURLをload_urlと定義。

html = requests.get(load_url)

# htmlをrequestのgetというメソッドを使い、 するものだと定義する。

soup = BeautifulSoup(html.content, "html.parser") # HTMLを解析する

#ちょっとよく分からない。

# ~ここまでで、HTML全体を表示するプログラムは完成~

menu_all = soup.find_all(class_ = "menu-list")

# menu_allと定義します。

for menu in menu_all :

#for 関数 in リスト でmenuの中にmenu_allを何回も入れていきます。

menu_name_full=menu.find_all('h4',attrs={'class':'menu-name'})

#menu_nameを全て探すことを、menu_name_fullと定義します。

for menu_name in menu_name_full :

#menu_nameの中にmenu_name_fullを何回も入れていきます。

print(menu_name.text)

print()

#printで指定したものの表示と、見やすいように空白を表示しています。それぞれのコードの詳しい説明は#で書いてある文を参照してみて下さい!

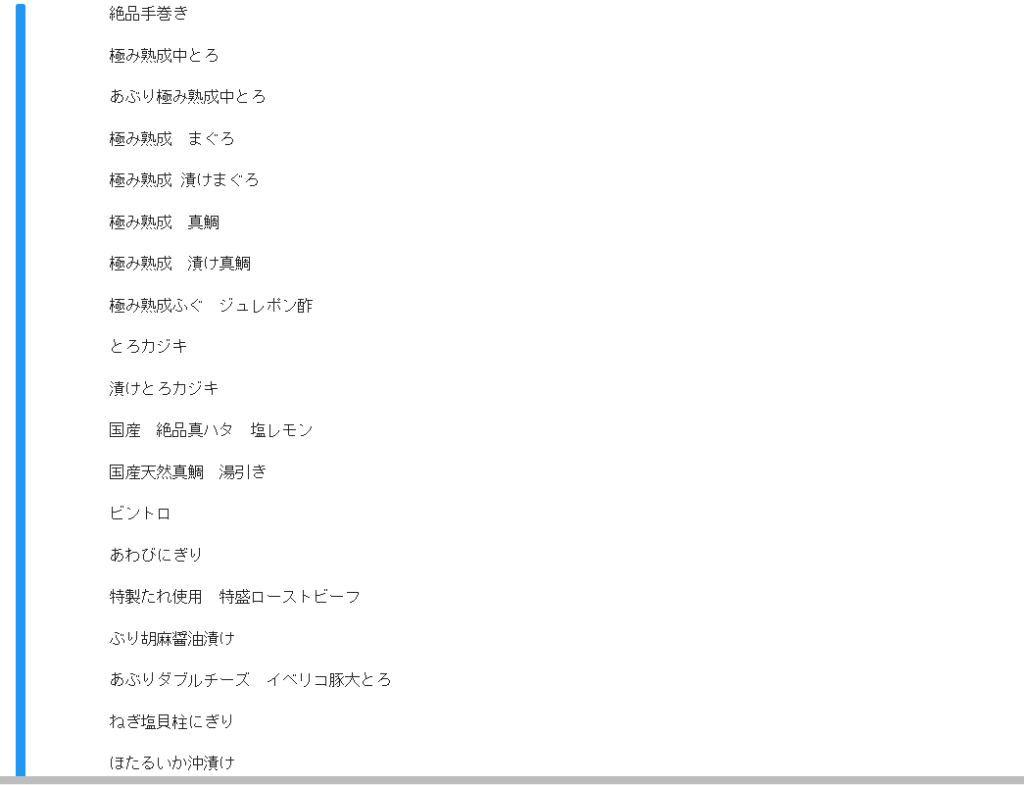

これを実行すると、、、

メニュー一覧が出てきます。。

やってることそんなに難しそうじゃ無いじゃんか。

って思うかもしれませんが、

実際やってみると結構重めです……

なかなか理解出来ずに困ってましたが、

周りの助けも有りなんとか完成できました!

手伝って下さりありがとうございました。

今回のものは、メニュー一覧だけの表示となっていますが、

カロリーや値段も対応して表示出来ると、

データサイエンスみが増しますね。

また、完成したら投稿したいと思います。

ではでは。

あ、あと興味があればぜひ最新の投稿もご覧下さい!

おはようございます。magnetです。

ずっと前に以下のページで streamlit を使ったWEBページを紹介しました。

(興味があればこちらもご覧下さい!)

そこで、今回はレポート作成に役立つようなサイトを作りたいと考え、

なるものを作りました。

https://share.streamlit.io/maglill/saisyonoyatu/main/mojisuu.py

上記のURLから飛ぶことが出来るので一回見てみて下さい!

これはサイト名通り、Wordなどに書いた文字をコピー&ペーストしてカウントボタンを押すと文字数をカウントしてくれます。

WordとかGoogleドキュメントに文字数を数えてくれる機能があるのは知りません笑

改善点としては英単語とかは文字数ではなく単語数が主流なので、正確に数えてくれません。

例えば、yesは3文字、weは2文字、canは3文字というようになります。

あくまで文字数ですからね~……

気分によって使い分けてみては?

最後に、コードを貼って終わりとします。ここまでご覧頂きありがとうございました!

import streamlit as st

st.title('文字数カウントサイト')

st.write('')

#ただの改行

'このサイトは入力された文章の文字数をカウント出来るサイトです。'

'「文字数足りてるかな?」と思ったら活用してみて下さい。'

st.write('')

#ただの改行

text=st.text_input('↓ ↓ ↓ 入力してね ↓ ↓ ↓')

#これ1つでテキストボックスも完備。

st.write('')

#ただの改行

n=len(text)

#textをnと置く。

if n==0:

st.write('文字が入力されていないよ。')

#未入力の時

if st.button('カウント'):

st.write('文字数は',n,'です。')

#ボタン押したとき文字数表示

if n==0:

st.write('nothing in the textbox. are you kidding me :△')

elif 1100<= n <=1300:

st.write('およそA4一枚程度だよ。')

elif 20000<= n <=40000:

st.write('おおよそ卒業論文の文字数だよ。')

else:

st.write('')